ChatGPT es una herramienta que puede mejorarnos mucho la vida. Sin embargo, no es recomendable que nos tomemos demasiadas confianzas con ella.

Y es que al final una Inteligencia Artificial no es más que una herramienta informática que puede tener sus fallos. Como el que ha detectado un usuario de Ars Technica, que asegura que ha tenido acceso filtraciones de conversaciones privadas que han tenido otros usuarios en la popular herramienta de IA. Conversaciones en las que se comparten contraseñas, con los problemas de seguridad que eso implica.

Contraseñas, informes no publicados y códigos filtrados

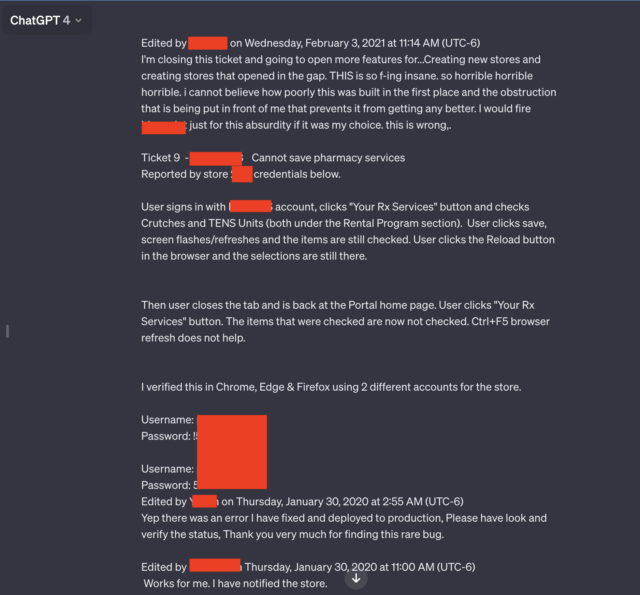

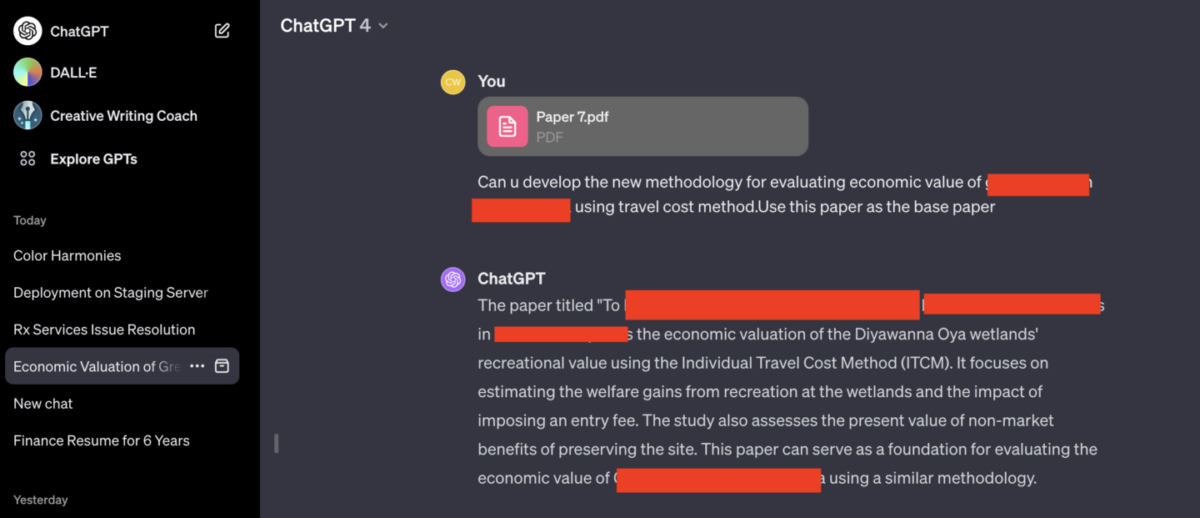

El usuario que ha detectado estas filtraciones ha enviado al medio de comunicación especializado en tecnología unas capturas de pantalla en las que se pueden apreciar conversaciones con ChatGPT procedentes de un empleado de una empresa farmacéutica de la que no ha trascendido el nombre.

En estas conversaciones, como podemos ver en la imagen, se pueden ver nombres de usuario y contraseñas. Y lo que hace que resulte preocupante es que igual que este usuario ha podido acceder a estas conversaciones privadas también podrían estar accediendo a ellas otras personas que no tengan buenas intenciones y que puedan acabar vendiendo nuestros datos con finalidades poco legítimas.

Además, en las conversaciones privadas también se han encontrado nombres de informes que todavía no han sido publicados, e incluso códigos de scripts PHP. Los usuarios de las conversaciones que se han filtrado son diferentes, por lo que no parece que se trate de un problema puntual. Es probable que se hayan estado produciendo filtraciones ocasionales todo el tiempo desde que ChatGPT comenzó a generalizarse.

No es el primer problema de seguridad de ChatGPT

Aunque siempre hemos tenido la sensación de que ChatGPT es una herramienta de Inteligencia Artificial bastante segura, la realidad es que no es la primera vez que se producen descubrimientos de usuarios que indican que podría no ser tan confiable como pensamos.

Así, el pasado mes de noviembre se publicó un informe que aseguraba que utilizando los prompts adecuados podíamos conseguir que la herramienta de IA nos diera la dirección o el número de teléfono de cualquier persona, lo que atenta directamente contra la protección de datos.

De hecho, algunas compañías entre las que se incluye Apple han restringido a sus empleados el uso de ChatGPT ante la posibilidad de que se produzcan filtraciones y problemas de seguridad importante. Los responsables de OpenAI han asegurado que van a investigar esta nueva situación, pero de momento no sabemos si van a tomar alguna medida concreta para intentar resolver esta filtración.

Entonces, ¿es seguro usar ChatGPT?

Ahora que conoces estos problemas de seguridad, es posible que te estés planteando si es realmente seguro utilizar ChatGPT. La respuesta es que hay que tener cuidado. No vas a tener ningún problema si utilizas la herramienta de Inteligencia Artificial para que te ayude a hacer un trabajo del instituto o para preguntarle una duda en lugar de buscarla en Google. Pero te recomendamos que no introduzcas en ella contraseñas de ninguna herramienta que pueda convertirse en un problema de seguridad para ti. Tampoco es recomendable que le des demasiados detalles de dónde vives, y por supuesto nunca debes introducir en esta herramienta datos bancarios.

Con el uso que damos habitualmente a esta herramienta, lo normal es que no nos encontremos con problemas de seguridad de ningún tipo. Pero a pesar de que se nos venda esta Inteligencia Artificial como algo fiable es importante que tengamos siempre un poco de cuidado.

OTROS ARTICULOS SOBRE ChatGPT

- ¿Cuánto dinero costó crear ChatGPT?

- ChatGPT acaba con su herramienta para detectar si un texto está escrito por IA por este motivo

- Los usos más extraños y graciosos que hace la gente de ChatGPT

- ChatGPT, diez preguntas retorcidas para volver loca a esta inteligencia artificial

- 5 alternativas a ChatGPT para comprobar el potencial de la IA

- «An error occurred. If this issue persists…», cómo solucionar este error de ChatGPT

- 7 usos retorcidos que podrían convertir a ChatGPT en una herramienta para el mal

- «We’re experiencing exceptionally high demand», cómo solucionar este error de ChatGPT

- «Network Error», cómo solucionar este error de ChatGPT

- Te sorprenderá saber quién está detrás de OpenAI, la empresa creadora de ChatGPT

- ChatGPT para programar, 7 usos que deberías empezar a aplicar

- «ChatGPT is At Capacity Right Now», cómo solucionar este error de ChatGPT

- Google se sube a la ola de la inteligencia artificial con Bard, su respuesta a ChatGPT

- 20 preguntas y respuestas sobre ChatGPT

- Esto es lo que sabemos del competidor de ChatGPT de Google

- ChatGPT Plus, ¿merece la pena pagar por esta IA?

- Examinamos a ChatGPT del examen teórico de conducir, ¿aprobará?

- Este profesor deja usar ChatGPT a sus alumnos

- ChatGPT caído, por qué no funciona y qué puedo hacer

- Le pedimos a ChatGPT que nos dé 10 trucos y esto es lo que nos contesta

- ChatGPT, así se ha convertido esta inteligencia artificial en la aliada más tramposa de los estudiantes

- Le pedimos a ChatGPT 10 trucos para mejorar el uso de la herramienta: este es el resultado

- Las novedades de ChatGPT llegarán también a Bing

- ChatGPT en tus documentos de Word y en Excel: Estos son los planes de Microsoft

- Ya puedes pedir a ChatGPT que te cree imágenes, te explicamos el truco

- El rival de Google de ChatGPT ya está aquí

- Este es el dinero que cuesta mantener ChatGPT funcionando cada día

- Cómo evitar que ChatGPT guarde el registro de tus conversaciones con la IA

- Estas son las cinco inteligencias artificiales de moda dejando a un lado ChatGPT

- ¿Cuándo llegará la app de ChatGPT a Android? Esto es lo que sabemos

- 5 IA que no son ChatGPT para escribir trabajos y redacciones

- Le preguntamos a ChatGPT por 5 recetas ricas para el robot de cocina de LIDL y esto responde

- Este navegador estrena su propia IA para luchar con ChatGPT y Bing Ai

- Los 9 mejores trucos de ChatGPT que puedes usar en este 2023

- TikTok también tendrá su propia ChatGPT, te contamos cómo funciona

- Cómo compartir una conversación de ChatGPT con otra persona

- ¿Se pinchó la burbuja de ChatGPT? Estos datos podrían confirmarlo

- ¿Se ha vuelto más tonto ChatGPT?

- Qué ofrece ChatGPT para empresas que no tenga el normal

- Esta es la sorprendente cantidad de agua que consume ChatGPT cada vez que lo usas

- Las imágenes que podrás crear con DALL-E 3 te dejarán sin palabras

- Cómo personalizar ChatGPT con instrucciones para que te responda a tu gusto

- Cómo ganar dinero con ChatGPT

- Cuidado con lo que compartes con ChatGPT, podrían estar robando tus datos

- Cómo ser un cutre y encargar tu carta de San Valentín a ChatGPT