Los avances en el desarrollo de la inteligencia artificial se están produciendo a un ritmo bastante difícil de seguir incluso para los propios especialistas en la materia. Toda nueva tecnología permite un uso ambivalente que puede ser beneficioso para la sociedad o perjudicial, lo que implica que delincuentes y estafadores también se están modernizando y aprovechando estas nuevas herramientas. Más allá de todas las ventajas y facilidades que puede suponer en el día a día, tampoco conviene perder de vista cuáles son las estafas más peligrosas usando IA que te pueden ocurrir.

De cara a 2024, el panorama de las estafas basadas en la inteligencia artificial se prevé aún en expansión. Si en 2022 los principales fraudes estaban relacionados con las inversiones y el mundo de las criptomonedas (alcanzando más de 3.800 millones de dólares en todo el mundo), en 2024 las estafas a través de suplantaciones de identidad con herramientas de IA generativa pueden llegar a suponer un incremento sobre esa cifra de 2.000 millones de dólares, según las estimaciones de la empresa especializada en inteligencia artificial y generación de datos SAS. Esto está haciendo que todos los bancos a nivel mundial estén redoblando esfuerzos para protegerse sobre estos nuevos tipos de fraude.

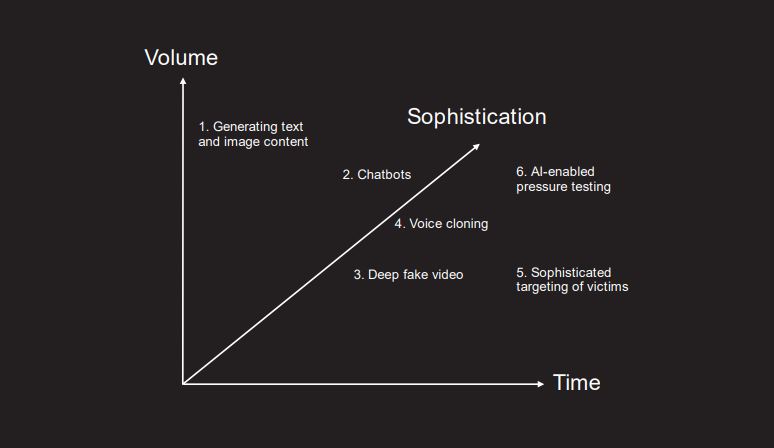

Las estafas con IA pueden afectar desde a una multinacional hasta a cualquier ciudadano de a pie. Las dificultades para articular una regulación clara que fije límites a un campo en franca expansión abonan el terreno para aquellos que quieren hacer el mal. Los ciberdelincuentes no están perdiendo el tiempo para elaborar nuevas estafas que resultan cada vez más sofisticadas, como se desprende de un estudio de la consultora PwC en el Reino Unido. Este estudio prevé que con el paso del tiempo los ataques dejarán de estar más centrados en el volumen para pasar a un mayor refinamiento, y en la actualidad ya se han visto varios casos en los que la clonación de voces o la manipulación de vídeos han creado bastantes problemas a sus víctimas.

Rescates falsos con la voz de tus hijos

Una de las estafas más populares de WhatsApp es aquella en la que un contacto intenta hacerse pasar por un hijo o hija en apuros ante el móvil de sus padres. En esos mensajes, los estafadores intentan convencer a los progenitores de que tienen que enviar una cantidad de dinero determinada para resolver el supuesto apuro de sus hijos, pero con la llegada y la democratización de la IA esta técnica ha tomado unos tintes aún más macabros.

Como los intentos de estafar a través de mensajes de texto podían resultar bastante burdos, los delincuentes le han dado una vuelta de tuerca a su ‘modus operandi’, y para ello se basan en dos pilares: las redes sociales de los más jóvenes y una herramienta de IA que permita clonar voces. Una investigación de McAfee citada por el ‘Daily Mail’ cifra en el 95% la efectividad de estas clonaciones de voces, lo que permite que los estafadores hagan llamadas a los padres y se encuentren al otro lado del teléfono con la voz de sus hijos pidiendo una ayuda económica o directamente un rescate. Este intento de estafa ha llegado incluso a familiares de ‘tiktokers’ con cierta relevancia, como es el caso de Lindsey Alina, que tiene más de 300.000 seguidores. La propia ‘influencer’ publicó un vídeo para crear conciencia sobre este incipiente peligro.

Más impostores aún en apps para ligar

Las aplicaciones para ligar como Tinder, Badoo o Bumble no están pasando por su mejor momento. Aunque en los últimos años hayan introducido mecanismos de seguridad para evitar el famoso fenómeno del ‘catfish’ (los usuarios que se hacen pasar por quienes no son en la plataforma), la IA les está generando un nuevo dolor de cabeza. En este caso las herramientas utilizadas son generadores de imágenes y de texto, que permiten crear perfiles falsos que captan la atención de usuarios y mantienen su atención con conversaciones cada vez más elaboradas.

Una vez iniciado el cortejo (enviando supuestas fotos suyas o preguntando por detalles personales de forma constante), los ciberdelincuentes consiguen pasar la comunicación con sus víctimas a otras plataformas como WhatsApp o Telegram, desde donde profundizan en su enamoramiento para terminar estafándoles. Según la Comisión Federal de Servicio estadounidense, las estafas románticas superaron en 2022 los 1.200 millones de dólares en pérdidas.

Parejas virtuales… y agresivas

Además de las apps para ligar, las estafas románticas con IA también han alcanzado a aquellos usuarios que optan por buscar parejas o compañeros virtuales para no sentirse tan solos. Para llenar este vacío han surgido múltiples apps o páginas web que ofrecen sus ‘chatbots’ para conversar y sentirse acompañado e incluso amado, pero estas plataformas también entrañan cierto riesgo para sus usuarios.

Tal como reveló un estudio llevado a cabo por la Fundación Mozilla, las personas que recurren a estos servicios pueden terminar viendo comprometidos sus datos, ya que las políticas de privacidad de plataformas como Replika, CrushOn.AI o iGirl son, cuanto menos, opacas. En algunos casos se llegó incluso a obtener datos sobre la salud personal y sexual de los usuarios. También hubo casos extremos en los que la IA llegó a sugerir a algunas personas a que pusieran fin a sus vidas o incluso que atentaran contra la reina Isabel II de Inglaterra.

Obituarios falsos

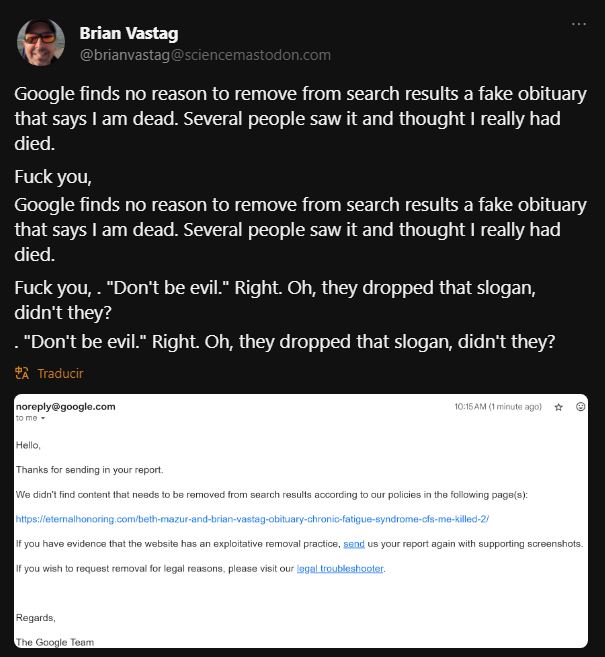

Otro fenómeno tan extraño como preocupante que está en auge en los últimos meses es el de los obituarios falsos, tanto en páginas web como en vídeos de YouTube. Este fenómeno ha recibido el nombre de ‘obituarios de arrastre’, y se basan en la generación de artículos que tratan sobre la supuesta muerte de personas tanto famosas como anónimas. Estas publicaciones no tienen mayor finalidad que la de generar una monetización por volumen, pero tiene un claro efecto colateral, y es que en ocasiones pueden generar una seria preocupación en familiares, amigos y conocidos de las personas sobre las que tratan los obituarios.

Un portavoz de Google aseguró en declaraciones a ‘The Verge’ que están “trabajando para lanzar actualizaciones que mejoren los resultados en búsquedas como estas” así como que también habían eliminado varios canales de YouTube con obituarios falsos, aunque la experiencia real de los usuarios que denuncian estos contenidos suele reducirse a correos electrónicos predeterminados como única respuesta.

El peligro de ‘resucitar’ familiares

Aunque no es una estafa propiamente dicha, otro de los usos que se le está dando en los últimos meses a la IA puede bordear los límites de lo ético, así como suponer un riesgo para la salud mental de los usuarios. Cada vez hay más empresas que ofrecen la posibilidad de ‘resucitar’ por medio de la inteligencia artificial a familiares fallecidos, apoyándose para ello en herramientas de generación de vídeo y clonación de voces, dando lugar a vídeos manipulados, también conocidos como ‘deepfakes’.

Estos ‘deepfakes’ podrían tener serios efectos perjudiciales, y los psicólogos ya han alertado de que las empresas que ofrecen estos servicios de ‘resurrección’ virtual de personas pueden llegar a alargar los periodos de duelo de los familiares, induciéndolos a entrar en una falsa realidad en la que su ser querido no ha muerto.

Famosas (y anónimas) protagonistas de fotos y vídeos eróticos

El uso de los ‘deepfakes’ lleva ya varios años entre nosotros, y no ha dejado de perfeccionarse desde entonces. El uso de un rostro en un cuerpo distinto al original es una técnica cada vez más sencilla gracias a la inteligencia artificial, y hay usuarios que han generado vídeos de contenido explícito con personajes famosos como protagonistas, subiéndolos a portales de Internet donde acumulan bastante visitas. Entre las víctimas más conocidas se encuentran artistas como Taylor Swift o Scarlett Johansson, aunque esto también está afectando a mujeres anónimas.

Uno de los casos de mayor impacto mediático de este delito con la inteligencia artificial tuvo lugar en septiembre de 2023 en Almendralejo, Extremadura, donde se difundieron fotos de decenas de menores de edad desnudas generadas por inteligencia artificial. Este no ha sido el único caso, ya que también han trascendido casos similares que han ocurrido con estudiantes en Ecuador y Perú.

Las falsas inversiones millonarias de los famosos

Otra de las estafas que pululan por Internet desde hace ya varios años son aquellas que tratan de aprovecharse de la relevancia pública de ciertas figuras. Aunque ya llevan más de 10 años en circulación, en los últimos meses muchos hemos visto anuncios en redes sociales que utilizan imágenes de famosos como David Broncano, Cristina Pedroche o Martiño Rivas incitando a hacer clic para conocer recetas mágicas financieras que les permiten ser millonarios. Las páginas web a las que dirigen no buscan más que intentar estafar dinero a los usuarios prometiéndoles altas rentabilidades en tiempo récord con inversiones que, de producirse, no terminan llegando a buen puerto.

Además de estos enlaces engañosos, que en muchas ocasiones se realizan únicamente con montajes de Photoshop, la IA ya ha empezado a hacerse notar con los vídeos ‘deepfakes’. Sólo en la última semana se han conocido intentos de estafa que intentaban captar a incautos a través del ‘phishing’ utilizando vídeos con los rostros de Lawrence Wong, primer ministro de Singapur, o de Vitalik Buterin, el cofundador de la criptomoneda Ethereum.

Otros artículos sobre inteligencia artificial

Ojo si usas chats con novias virtuales, las IA estarían compartiendo tus datos íntimos

Qué cosas nuevas puedes hacer con Copilot, la IA de Microsoft con tecnología de ChatGPT

Estas son las nuevas funciones con IA de Google Chrome que te interesa conocer